On entend parfois parler de la « matière exotique » ou d’« atomes exotiques ». Je ne parlerais ici que de la seconde (le reste sera pour une autre fois).

Si les atomes normaux sont connus de tous, avec leurs protons, leurs neutrons et leurs électrons, les atomes exotiques sont des formations atomiques un peu particulières.

Je vais d’abord avoir besoin de faire un bref point sur les atomes ordinaires et le modèle standard de la physique quantique.

Les atomes

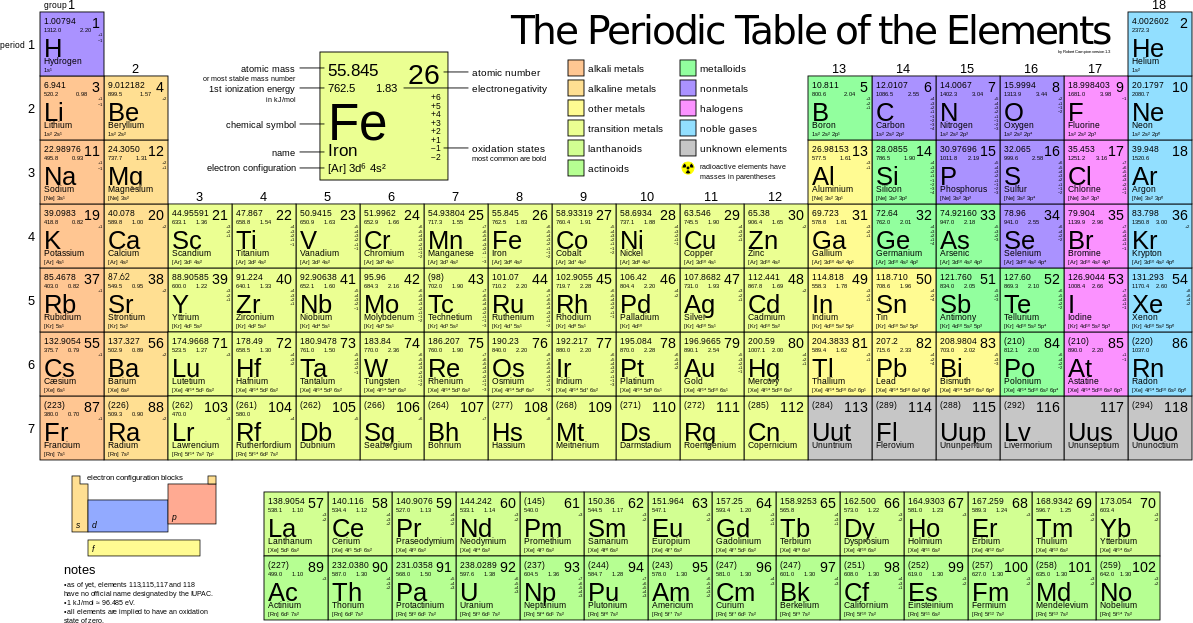

Je pense que tout le monde est plus ou moins familier avec ce tableau :

Toute la chimie, tous les objets, toute la biologie et la vie, vous et moi sont composé d’éléments présents uniquement dans ce tableau.

Si tous ces éléments présentent déjà beaucoup de curiosités, comme l’or et sa couleur, le plutonium ou le fer, présent dans le sang, ça n’est pas assez pour le scientifique fou dans son labo et on peut créer plein d’autres choses.

Les atomes exotique donc, c’est quelque chose de bien différent de ce que nous connaissons et, je vous le dis tout de suite, on ne risque d’en trouver ni dans la nature ni dans les magasins (en tout cas pas dans un futur proche et probablement pas dans notre univers).

Le modèle standard

En physique quantique, on parle du modèle standard pour définir et classer les différentes particules élémentaires de la matière qui existent :

On retrouve, tout en bas à gauche, l’électron.

Le proton et le neutron sont formés des quarks up et down (3 chacun : 2 up + 1 down et 1 up + 2 down respectivement). Enfin lors de la désintégration radioactive de certains atomes il est parfois émis un neutrino électronique. Ces quatre particules sont toutes dans la première colonne du tableau.

Maintenant, si on considère la dernière ligne, on voit que les caractéristiques spin et charge de l’électron, du muon et du tau sont identiques. Seule la masse (ou l’énergie) varie. Chaque ligne regroupe en fait des particules ne différant que par leur masse et chaque colonne regroupe les éléments par « génération » selon la masse ou l’énergie : la première colonne regroupe les basse énergie, la seconde d’énergie moyenne et la dernière de haute énergie.

Fait d’électrons, de protons et de neutrons, nos particules et notre monde correspondent à la basse énergie du modèle standard. Toute la physique que l’on observe, incluant ce qui se passe dans le tableau périodique, la chimie ou les centrales nucléaires et le cœur des étoiles concerne cette physique de basse énergie. La basse énergie est celle qui est la plus stable et c’est sûrement pour ça que notre univers est composé presque uniquement de ces particules là.

D’autres univers pourraient être fait des niveaux d’énergie supérieurs au notre, mais on n’a pas encore de quoi les observer. On observe en revanche des particules isolées de moyenne et haute énergie ! Par exemple, quand les rayons cosmiques très énergétiques frappent l’atmosphère, une partie de l’énergie est transformée en particules très massives : des muons.

Le muon est l’équivalent plus énergétique de l’électron, et, malgré sa durée de vie de seulement 2,2 µs, on est capable de faire des atomes avec !

C’est ce genre d’atomes, constitué d’un assemblage de particules que l’on n’a pas l’habitude de voir, qu’on nomme « atomes exotiques ».

Les atomes exotiques

L’hydrogène muonique

Je viens de le dire : il est possible de remplacer un électron par un muon, vu qu’il a la même charge.

Si l’on prend un proton que l’on associe à un muon, on obtient un atome d’hydrogène muonique.

Étant donnée que le muon est bien plus lourd que l’électron, le muon qui tourne autour du noyau est sur une orbitale bien plus proche de ce dernier et l’atome est beaucoup plus petit.

Cette particularité a plusieurs applications potentielles, comme la fusion nucléaire froide catalysée par muons. Normalement, pour faire fusionner des atomes, on doit les chauffer à des températures proches de ce que l’on trouve dans le cœur du Soleil (15 millions de degrés) si ce n’est beaucoup plus si on veut s’affranchir de la fusion probabiliste par effet tunnel, auquel cas il faut chauffer à près de 100 millions de degrés.

Ces températures sont nécessaires pour permettre à deux atomes et leurs noyaux de se rapprocher suffisamment pour fusionner. L’atome d’hydrogène muonique étant plus petit, il est plus simple de le fusionner et les températures requises sont moins hautes. L’un des plus gros problèmes pour un réacteur nucléaire à fusion froide catalysée par muons, c’est la durée de vue trop courte des muons (2,2 µs).

Le muonion

Les anti-particules sont opposées à nos particules selon divers caractéristiques quantiques dont la charge. Chaque particule se voit associer une anti-particule : l’électron avec son anti-électron (ou positron) ou le neutrino électronique avec l’anti-neutrino électronique sont les plus courantes car rencontrées dans la désintégration radioactive depuis longtemps.

Les muons ont aussi leur anti-particules : l’anti-muon. Sa charge est alors positive et est donc la même que le proton ou le positron.

Devinez quoi ? On peut remplacer un proton par un anti-muon ! Si on fait ça dans un atome d’hydrogène, on obtient un électron orbitant autour d’un anti-muon : le muonium.

Cet atome exotique, découvert déjà en 1960, possède même son propre symbole chimique : Mu (informel).

Cet atome exotique conserve (grâce à l’électron) les propriétés chimiques de l’hydrogène, et on a réussi à faire de l’eau muonique appelé hydroxyde muonique (HOMu), du chlorure de muonium (MuCl) ou du méthane contenant du muonium : le muoniométhane.

Encore une fois, tous ces atomes ont une durée de vie très courte à cause de l’anti-muon qui est très instable (et qui finit par se désintégrer spontanément après 2,2 µs en moyenne).

Les oniums : positronium et protonium

Un onium est une structure atomique où une particule chargée orbite autour de son anti-particule, de charge opposée (mais de masse identique).

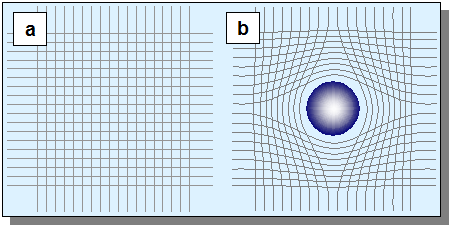

Si l’électron orbite un positron, on obtient un atome de positronium. On a bien deux ici particules de charges opposées, mais contrairement à l’atome classique où le noyau est environ 1 000 fois plus lourd que l’électron on a ici une particule et son anti-particule de masse identique. Les deux sont donc pris dans une sorte de danse autour d’un barycentre commun :

Comme le muonium, le positronium a été synthétisé (depuis 2007), elle possède un symbole « Ps » et on a prédit des molécules positroniques, où cet atome exotique remplace un atome d’hydrogène : le PsH, le PsCl, le PsLi ou encore le Ps2 ont été observées.

Ces molécules et le positronium lui-même sont très instables (durée de vie de 100 ns) et se terminent par une annihilation matière-antimatière.

À la place de l’électron, on peut prendre le proton et l’antiproton : l’atome exotique ainsi obtenu est le protonium, dont le symbole est pp (reprenant le symbole « p » du proton et le « p-barre » de l’anti-proton).

Cet atome exotique a la particularité d’être le théâtre d’une bataille entre l’interaction forte et l’interaction électromagnétique. Là aussi cet ensemble est très instable et se termine en annihilation matière-antimatière.

Le pionium

J’ai dit plus haut que le proton et le neutron sont chacun formés de 3 quarks. Ce sont dès lors des baryons.

Des assemblages de seulement 2 quarks sont appelés des mésons et on peut former des atomes exotiques avec des mésons !

L’une des catégories de mésons sont les mésons-π (Pi), qui existe en trois exemplaires : π⁺, π⁻, π⁰.

Quand on fait un atome exotique avec le méson-π⁺ et le méson-π⁻ orbitant l’un autour de l’autre, on obtient un pionium.

Considérant qu’il existe 2 formes de quarks de basse énergie (up et down) et que chacun possède sont antiparticules (anti-up et anti-down) et qu’on a la même chose pour les quarks d’énergie moyenne et élevée, on obtient toute une collection de mésons différent : pions (π⁺, π⁻, π⁰) kaons (K+, K−, K⁰ Ks⁰, Kl⁰), Êta (plusieurs variantes là aussi)… et autant d’anti-mésons. Tous sont susceptibles de former des atomes exotiques, même si très peu ont encore été synthétisées ou observées.

En plus du pionium, on peut parler de l’hydrogène kaonique : c’est un proton autour duquel il orbite un kaon K⁻. Si on avait deux kaons à charge opposée, on parlerait de kaonium, mais ils n’ont pas encore été observés.

Atomes hypernucléaires

Quand on regarde le tableau du modèle standard, on peut dire que le quark strange « s » est au quark down ce que le muon est à l’électron. Or, le quark down est un composant des nucléons que sont le neutron et le proton.

Vous le devinez : on peut faire un nucléon contenant un quark strange : ce sont alors des hypérons, comme le Σ (sigma), le Ξ (xi) ou le Ω (oméga).

Si cet hypéron est placé dans un atome à la place d’un nucléon, alors on obtient un atome hypernucléaire.

En raison de la forte masse (pour une particule, hein) des quark strange, ces derniers sont très compliqués à produire et aussi très instables (durée de vie de l’ordre de la nanoseconde) et finissent pas se désintégrer en énergie, mésons et baryons (protons et neutrons).

Je termine ma liste sur l’atome hypernucléaire, mais j’espère que ça vous a montré un peu l’ampleur des possibilités offertes par la physique des particules. Alors que le tableau périodique permet de voir tout le « bestiaire » de la chimie, le noyau de l’atome est à lui seul un autre monde rempli de quarks, qu’il est possible d’assembler en mésons, hypérons et d’autres particules et atomes exotiques. C’est un peu ce qu’ils font au Cern dans le LHC et dans les autres accélérateurs de particules dans le monde.