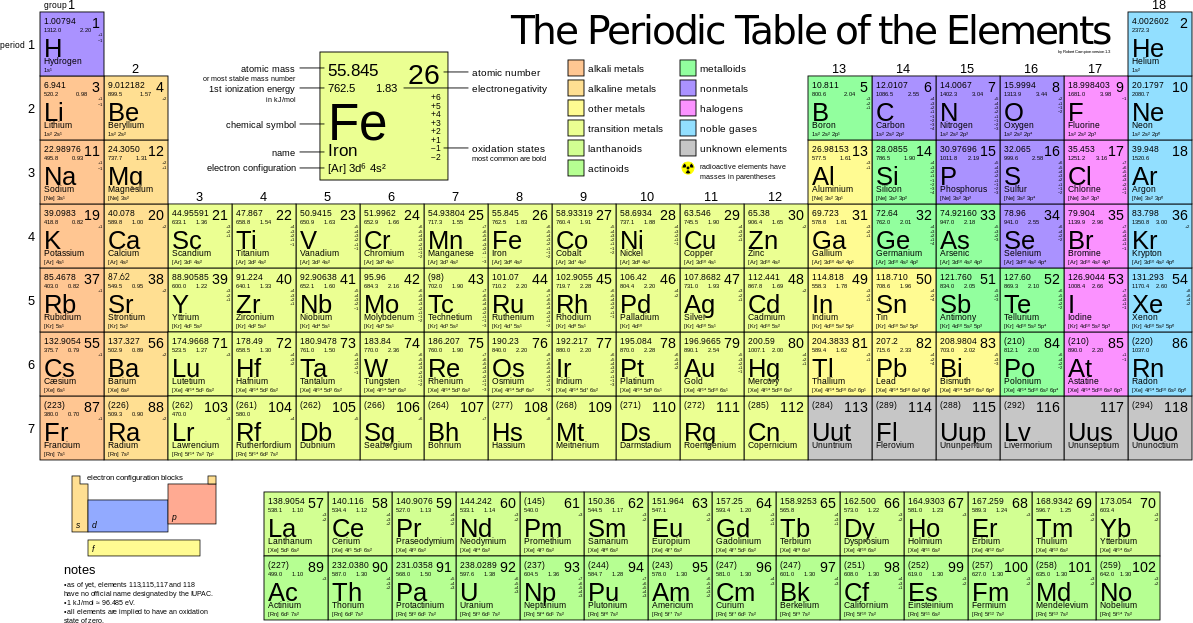

Pour ce second article, on va voir comment ces semi-conducteurs peuvent former la brique élémentaire de l’informatique moderne : le transistor.

La Diode et le Transistor

La diode est l’équivalent beaucoup plus petite, beaucoup plus pratique, beaucoup plus robuste que les anciennes ampoules à vide utilisées dans les premiers ancêtres d’ordinateurs. Ces ampoules utilisaient une borne émettrice d’électrons à très haute tension et une autre borne qui les réceptionnait. L’ensemble était asymétrique et les électrons ne pouvaient passer que dans un seul et unique sens (le principe de la diode).

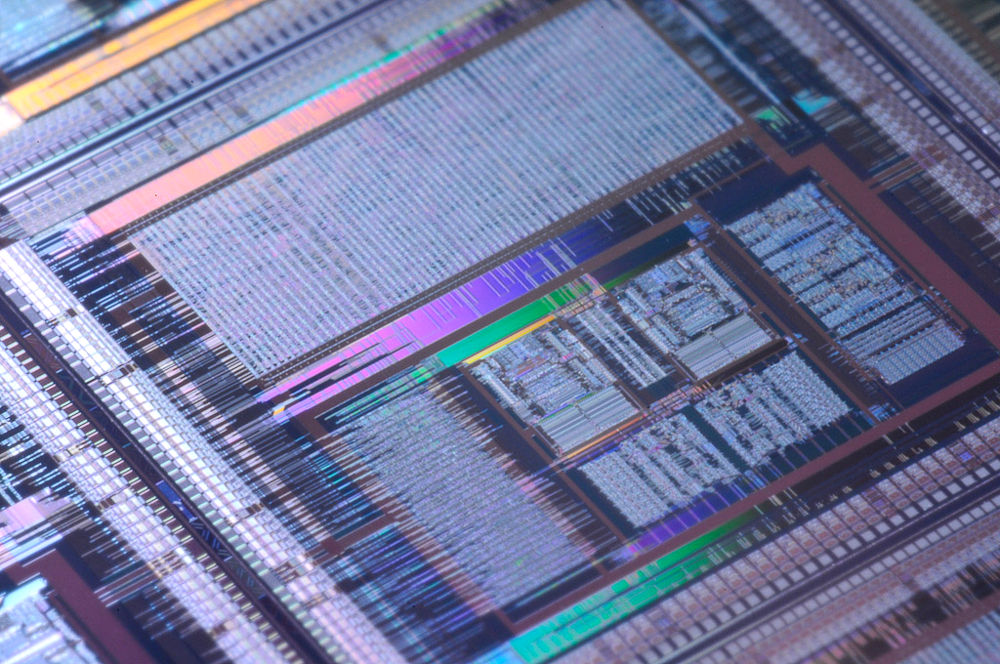

Ces ampoules à vide étaient grandes, chauffaient, nécessitaient des hautes tensions… bref, l’informatique méritait mieux que ça. Heureusement, depuis on a inventé les circuits intégrés : ce sont des semi-conducteurs gravés qui font office de composants électroniques. Ces derniers sont désormais beaucoup plus petits, ne chauffent pas ou peu et sont bien moins fragiles et moins chères.

Par exemple, le transistor est tellement miniaturisé que votre ordinateur ou votre téléphone en contient plusieurs centaines de millions, voire plusieurs milliards, sur une simple puce de silicium.

La diode, comme son nom laisse penser (le « di- »), est composé de deux morceaux de semi-conducteurs : un morceau de semi-conducteur dopé P, et un morceau dopé N (on parle de diode PN).

Le transistor, lui, est un composant à trois bornes qui est composé de deux diodes collées l’une à l’autre de façon à former une suite N-PP-N : le transistor NPN ou une suite P-NN-P (donc PNP).

Anatomie d’un transistor

Comme je l’ai dit au dessus, le transistor est un tripôle correspondant à une juxtaposition de semi-conducteurs dopés N et P. Dans ce qui suit, on prendra comme base le transistor NPN en silicium.

Dans les faits, c’est un sandwich de silicium P entre deux tranches de silicium N :

Le fait que l’on utilise des semi-conducteurs dopés différemment, on observe plusieurs phénomènes dans le transistor, notamment aux jonctions NP et PN.

Souvenez-vous, les semi-conducteurs dopés N sont surchargés d’électrons : le cristal de semi-conducteur contient des électrons « libres » entre les atomes. Les semi-conducteurs dopés P contiennent des trous d’électrons : des emplacements où se trouve une liaison cristalline mais où il manque un électron.

Aux jonctions, et uniquement aux jonctions, certains électrons de la partie N va aller boucher les trous de la partie P.

On se retrouve donc avec les jonctions qui se retrouvent à la fois sans électrons libres et sans trous : les électrons du N sont partis boucher les trous du P. Cette jonction ne contient donc plus de charges conductrices introduites grâce au dopage :

Ce déplacement d’électrons au sein du cristal de silicium dopé va générer des régions chargées au niveau des jonctions : les zones N vont devenir positives (le phosphore se trouve ionisé positivement, car son électron en trop est parti) et les zones P de l’autre côté vont se retrouver négatives (le bore va se retrouver ionisé négativement, car son trou est bouché par un électron).

Si les électrons et les trous ne participent plus à la conduction du courant au niveau de ces jonctions, ils représentent donc une différence de charge au niveau moléculaire :

À ce stade, le transistor n’est pas encore branché dans un circuit : les zones chargées sur les jonctions sont présentes de façon naturelle au sein de la matière qui compose le transistor, simplement parce que des électrons se sont déplacés.

Ce phénomène de productions de zones chargées au niveau des jonctions est cruciale pour le fonctionnement du transistor. En fait, c’est là que naissent toutes les propriétés électroniques des transistors.

Fonctionnement d’un transistor

Voyons ce qui se passe quand on branche le transistor dans un circuit.

Le transistor dispose de trois bornes :

- le collecteur ;

- la base ;

- l’émetteur.

Le collecteur et l’émetteur sont techniquement symétriques. La base est est un peu particulière.

Commençons par brancher le collecteur et l’émetteur dans un circuit et à mettre le courant (on considère que la base n’est reliée à rien du tout).

Les premiers électrons qui vont arriver au collecteur vont être naturellement attirés par la région positivement chargée près de la jonction NP.

Une fois que cette région sera occupée par les électrons, ces derniers vont se retrouver devant à un mur : ils seront repoussés par la région négative dans la partie P du transistor. Les électrons ne peuvent donc pas passer vers l’émetteur.

De l’autre côté, les électrons de l’émetteur finissent par être aspirés dans le circuit, mais ils sont également attirés par la région positivement chargée à la jonction PN. De ce fait, le courant ne passe pas là non plus.

À ce stade, le transistor bloque complètement la circulation du courant.

(Évidemment, si on augmente la tension aux bornes C et E du transistor, le courant finira par passer quand-même : la différence de potentiel du circuit sera plus forte que les effets de répulsion qui empêchent les électrons de passer, mais dans ce cas là, ça correspondra au claquage du composant et résulterait également en sa destruction, ce qui n’est donc pas un comportement normal ni souhaité.)

Maintenant, mettons la base du transistor sous tension et observons ce qui se passe :

À cause de cette tension positive sur la base, des électrons commencent par être retirés de la base.

La conséquence de cela, c’est que les électrons du collecteur ne subissent plus de répulsion et ils peuvent maintenant se mettre à circuler sous l’effet de la tension principale entre le collecteur et l’émetteur.

En arrivant sur l’émetteur, les électrons vont boucher les trous (qui sont positifs), puis vont pouvoir passer dans le circuit.

La simple présence du courant sur la base suffit à supprimer la barrière d’électrons qui empêchait le courant principal entre le collecteur et l’émetteur de passer. Si on supprime ce courant de la base, les électrons qui vont arriver par le collecteur vont s’arrêter au niveau des trous dans la région P et finir de nouveau par bloquer le courant entre le collecteur et l’émetteur !

On a donc un comportement très particulier :

- en appliquant une petite tension à la base, le courant principal entre le collecteur et l’émetteur peur passer ;

- en supprimant cette tension à la base, le courant entre le collecteur et l’émetteur est coupé.

Ce comportement peut sembler anodin, mais il ne l’est pas : cet effet, parfois nommé effet transistor permet de contrôler un courant principal (circuit CE) avec un petit courant secondaire (sur la borne B). Il s’agit donc d’un sorte d’interrupteur électronique.

Le transistor est un interrupteur contrôlé électroniquement, sans partie mécanique.

Vous devinez peut-être la suite : que se passe-t-il si on branche plusieurs transistors à la suite, avec la sortie d’un transistor branché à la base d’un autre : ainsi, un transistor peut contrôler le suivant.

Les portes logiques

Si on met deux transistors à la suite, le second dépendra du premier quelque soit son état (bloquant ou passant).

Une chose est sûre cependant, c’est que pour qu’il laisse passer le courant, il faut obligatoirement que le premier laisse passer le courant lui aussi :

- si les entrée A et B sont nulles (tension nulle), alors la sortie est nulle ;

- si A est nulle mais que B n’est pas nulle, alors la sortie est nulle ;

- si B est nulle mais que A n’est pas nulle, alors la sortie est nulle ;

- si A et B ne sont pas nulle, alors la sortie n’est pas nulle (la tension à la sortie est (ici) de 5 V).

On appelle ce dispositif une « porte ET », dans le sens où le courant passe uniquement si l’entrée A et l’entrée B sont sous tension.

Il existe aussi la porte OU, où le courant passe à la condition que l’une des entrées au moins est sous tension.

Les portes logiques dans ce genre existe sous plein de formes. On a vu ET, j’ai mentionné OU. Citons aussi la porte NON (dont la sortie est l’inverse de l’entrée), la porte NON-ET (qui inverse la sortie d’une porte ET), la porte NON-OU, la porte OU-Exclusif (qui est une porte où l’une des entrées seule doit être sous tension, mais surtout pas les deux).

Ces portes logiques permettent de comparer des entrées (A et B) : si les deux entrées sont à 0 V, alors la porte ET ou OU afficheront également 0 V en sortie. Mais la porte Non-OU ou Non-ET afficheront 5 V en sortie.

Ces portes constituent le début des fonctions opératoires de base en électronique.

Avec quelques-unes de ces portes logiques, on commence à faire des calculs encore plus évoluées. Par exemple, on peut faire un additionneur sur deux bits avec retenue à l’aide de seulement cinq portes logiques :

L’addition se fait ici en binaire. Si je branche les bornes A et B, j’obtiens en sortie l’addition de A et B :

La borne Re, c’est pour brancher la sortie Rs (la retenue) d’un montage précédent identique. En grand nombre, ces montages entiers mis bout à bout permettent de faire des additions binaires beaucoup plus grandes !

Différents agencements permettent de faire des convertisseurs, des multiplicateurs, des diviseurs… Toutes les fonctions mathématiques de base, en fait, et avec elles, toutes les applications imaginables dans les programmes d’ordinateur.

Croyez-le bien : en grand nombre et assemblés, ce genre de montages, composés uniquement de transistors en silicium dopé, sont à la base des processeurs et des les composants actifs dans tous les ordinateurs, smartphones et systèmes numériques !

Dans le prochain article, je parlerai d’une fonction un peu particulière obtenue avec les transistors : la fonction mémoire. Des clés USB aux cartes mémoires en passant par les disques durs SSD, tous ces systèmes de stockage de données utilisent en effet des transistors pour stocker les données numériques sur le long terme.